Analyse de logs SEO : 10 bonnes raisons de les exploiter

L’analyse de logs serveur pour le SEO

L’analyse de logs est un terme quelque peu barbare, qui fait souvent peur aux néophytes, et semble incroyablement compliqué.

En réalité, lorsqu’elle est bien menée, cette analyse est une véritable mine d’or pour optimiser son référencement naturel . Elle vous permet d’avoir des informations très, très, très précises sur ce qui se passe sur votre site internet, aussi bien du côté des internautes que des moteurs de recherche.

Nous allons voir ensemble les 10 raisons pour lesquelles cette analyse SEO révèle des informations très pertinentes sur votre site, et peut vous permettre de dépasser vos concurrents sur Google.

Qu’est-ce que l’analyse de logs ?

L’analyse de log est une action qui, lorsqu’elle est bien menée, vous permet de ressortir énormément d’informations sur votre site internet.

Par exemple, cela peut vous permettre d’identifier une partie de votre site que les robots des moteurs de recherche ne visitent pas, mais aussi quelles pages semblent leur « plaire » le plus.

L’analyse peut être menée avec différents objectifs, que ce soit purement technique, SEO, ou encore marketing.

Pourquoi analyser les logs de son site internet ?

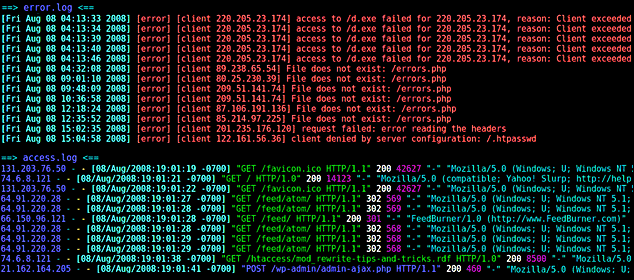

“Les logs serveur ne mentent pas”.

Si votre Google Analytics est généralement très fiable (s’il bien configuré), la réalité est que les logs serveur sont véritablement la référence ultime, on y trouve tout ce qui s’est passé sur votre site. Que ce soit le cheminement d’un internaute, ou le passage des robots.

Ces derniers nous intéressent tout particulièrement : en effet, cela permet à un référenceur web de savoir très exactement quand est passé le robot Google (mais aussi Bing, Yahoo, Qwant ou autre moteur de recherche) sur votre site.

Ce qui est très important, au-delà de la dimension temporelle, c’est que les logs permettent également de définir où le robot passe (sur quelles pages), ou bien, où il ne passe pas.

À ce moment le travail d’analyse devient très intéressant. Mais l’analyse des logs en soit, n’est que le début, et ne permet pas toute seule de tirer des conclusions.

Le budget crawl

La notion de budget crawl a été popularisée par l’outil de crawl Botify.

Elle a depuis été confirmée par Google (en anglais).

Mais alors qu’est-ce que le budget crawl ?

Si vous vous amusez à analyser les documents financiers de Alphabet, vous découvrirez parmi leurs dépenses principales, la consommation d’énergie. En effet, les serveurs de la firme de Mountain View tournent 24h/24, 7jours/7, et 365jours/an. Leur objectif est donc de rationaliser la découverte des sites mondiaux par leurs robots, afin de trouver les pages pertinentes pour les internautes et utilisateurs du moteur, mais aussi pour ne pas retourner voir des pages sans valeur, et rationaliser ainsi la dépense d’énergie.

Alléger le temps de passage du robot Google ?

Le budget crawl est donc le temps de passage du robot que Google vous attribue. Une fois cette notion intégrée, on peut mettre différentes optimisations en place : bloquer des pages aux robots car elles n’apportent pas de valeur SEO au site, et reporter ainsi le budget crawl sur des pages que l’on veut que le robot visite souvent, par exemple (plus d’informations sur ce sujet dans un futur dossier).

Analyser le comportement du robot Google sur son site

Ainsi, l’analyse de logs vous permettra également d’analyser le comportement du robot sur votre site, et de mener des améliorations pour bénéficier au maximum de votre budget crawl pour votre site.

Comment analyser les logs de son site ?

Voyons tout d’abord comment analyser vos logs serveur.

Une information importante à savoir : si votre site ne bénéficie pas d’au moins un petit milliers de pages, l’analyse risque de ne pas être très pertinente (cela reste à voir au cas par cas néanmoins). Par contre, un petit site peut être une bonne opportunité de vous faire la main ;) .

Rentrons dans le vif du sujet :

La première chose à faire est de récupérer vos logs serveur. Généralement ils sont accessibles en ligne sur votre hébergement. Si cela n’est pas cas (et ça arrive) nous vous conseillons de contacter votre hébergeur directement afin qu’il vous communique la procédure pour les récupérer. La plupart du temps, votre support sera capable de vous les envoyer sous un délai raisonnable.

Si vous avez accès directement à vos logs, surtout ne téléchargez pas l’ensemble directement.

En effet, comme nous vous le disions ci-dessus, vos logs contiennent toute l’activité sur votre site, et donc toutes les actions des internautes et des robots. Si votre site contient plusieurs milliers de pages, et que vous avez un nombre important d’internautes mensuels, cela risque de générer un fichier trop volumineux et totalement inexploitable.

Pour s’assurer de récupérer un document de travail propre il nous faut commencer par quelques manipulations :

- Tout d’abord nous n’allons nous intéresser qu’aux passages de Google, et donc éliminer les passages des internautes et des autres robots. Cela permettra d’alléger le fichier. De plus, Google utilise différents robots pour différents contenus (images, vidéos, actualités, etc.) Nous allons donc affiner le champs d’analyse en nous focalisant sur le robot desktop soit user agent = Googlebot.

Pour trouver la liste complète de bots Google, vous pouvez vous référer au document mis en ligne sur le support pour les webmasters : Robots d’exploration Google.

Maintenant que nous avons les logs du Googlebot il nous faut les récupérer en document .csv afin que cela soit exploitable.

(Attention à reproduire également ce travail pour le Robot mobile… plus d’informations sur ce sujet d’ici quelques semaines, un dossier est en préparation.)

Trier les logs

Une fois le document récupéré, il est nécessaire de réaliser un travail de tri des données. En effet vous allez vous retrouver avec beaucoup de données inutiles. Dans un premier temps il est intéressant de ne garder par exemple que les colonnes « Date », « Code réponse », et « URL ». Cela permet de faire déjà un premier travail. Par la suite, à vous d’imaginer ce que vous pouvez retirer des autres données.

Vérifier l’intégrité des données de logs serveur

Avant de commencer l’analyse pure, pensez à faire un tour sur votre Search Console. Vous y trouverez des indications sur les pages explorées par Google. Si les données ne semble pas correspondre à ce que vous avez récupéré, cela risque de fausser l’analyse.

De même, il est nécessaire d’éliminer les faux googlebots (et oui il y en a) en effectuant un reverse DNS. La méthode à suivre : Vérification de Googlebot.

Croiser les données de logs avec celles du crawl et de l’analytics

Maintenant que nous avons nos données nettoyées, nous n’avons pas forcément plus d’informations qu’auparavant.

Nous allons donc croiser ces données avec d’autres sources : Google Analytics (ou tout autre service que vous pouvez utiliser), et les résultats de crawl de votre site.

Ces informations une fois croisées, nous permettent d’identifier les pages les plus visitées par les internautes ayant une source organique, et de les recouper avec les visites du robot. Cela vous permet d’identifier des pages orphelines visitées par le robot, mais pas par votre crawl. Ces pages sont peut-être mal positionnées, mais ont un intérêt business important pour vous. Vous pouvez ainsi prioriser votre travail d’optimisation de contenu.

Catégoriser les pages

Afin d’aller plus loin dans l’analyse, et aussi de la rendre plus digeste, vous pouvez travailler par catégories de pages. Cela vous permet, par exemple, d’assembler certaines URL afin de ressortir des données d’URL similaires (catégories de produits, catégories d’articles sur un site média, ou encore auteur des articles pour un blog ou site média, etc.).

Vous pouvez adopter une approche plutôt technique, par exemple en groupant vos pages selon les templates (pages listes, pages produits, pages catégories). Dans ce cas, vous pouvez, par exemple, les regrouper via un schéma d’URLs identique.

Ou bien adopter une approche plus marketing, en analysant par thématique de pages, en croisant les visites (analytics) / logs, et de favoriser plus ou moins certaines thématiques, travailler leur optimisation ou revoir la thématisation du site par exemple.

Enfin, et c’est ce qui nous intéresse, adopter une approche SEO, en récupérant les données Analytics et Search Console, cela vous permet d’analyser le positionnement de vos URLs (mots-clés longue, moyenne, et courte traine), leur trafic, et donc d’optimiser leur contenu.

Quand analyser les logs ?

Tout d’abord, un gros travail est nécessaire lors de la première analyse que vous allez mener. Tout simplement car il s’agit de définir ce que vous voulez connaître de votre site, et dans quel but, puis de récupérer toutes les informations nécessaires.

La première analyse vous permet de découvrir les problématiques techniques de votre site, d’identifier les pistes d’amélioration SEO , et de faire un premier check-up. Les données que vous récupérez peuvent remonter de un à trois mois précédents l’export des logs. Ainsi vous aurez assez de matière pour travailler.

Par la suite, il sera intéressant de mener une analyse continue (mensuelle, trimestrielle, suivant vos besoins) en la recoupant avec les optimisations que vous aurez apporté : technique (baisse du nombre de pages 404 ? meilleur maillage interne ?), de contenu (plus de passage du robot sur les pages anciennement oubliées au crawl ?). Ce travail vous permet véritablement de savoir comment Google réagit à vos optimisations, en allant au-delà d’un suivi de positions classique.

Quels outils utiliser pour l’analyse de logs ?

Plusieurs outils sont disponibles, certains payants d’autres en open-source. Vous pourrez en trouver à utiliser en local, mais aussi des services cloud.

Une liste (non-exhaustive) des services disponibles :

- OnCrawl : un outil Saas qui vous permet d’analyser votre site et d’en extraire de précieuses informations

- OnCrawl Opens source : un outil disponible sur Github qui vous permet de réaliser des analyses, mais moins poussées qu’avec l’outil Saas

- Kibana : autre outils open source, très pratique

- Kelogs : autre outil Saas, concurrent du premier

- Botify: Le pionnier de l’analyse de logs

Les 10 bonnes raisons de réaliser une analyse de logs :

Pour conclure, vous trouverez ci-dessous un résumé des meilleures raisons de réaliser une analyse de logs pour votre site internet, et améliorer ainsi votre référencement naturel.

- Savoir ce que le robot Google crawle sur votre site, et par extension, ce qu’il ne crawle pas.

- Savoir ce que Google « aime » sur votre site.

- Comprendre quelles thématiques / zones de votre site sont préférées par Google, et pourquoi (manque de contenu sur les zones peu visitées ? problématique technique ? etc.)

- Si vous identifier des blocages techniques, cela peut être un frein pour votre référencement. Cela vous handicape face à vos concurrents, et les résoudre vous permet de donner un coup de booste à la réactivité du site.

- Croiser les données (crawl, analytics) permet de ressortir des informations primordiales sur la santé et le comportement de votre site internet.

- Ratio de priorité d’action : les différentes problématiques remontées vous permettent de prioriser ce qu’il faut faire sur le site. Beaucoup de 404 ? un travail technique est nécessaire. Les pages peu explorées sont des pages ayant peu ou pas de contenu ? sortez votre clavier et coupez vos notifications afin de rédiger un contenu de qualité pour vos internautes.

- Analyser l’impact de l’architecture de votre site sur son référencement.

- Anticiper, suivre, et vérifier qu’une migration s’est bien passée.

- Optimiser votre budget crawl.

- Passer au niveau supérieur sur votre analyse SEO :)

Conclusion :

On nuancera l’analyse de log : ce n’est pas une solution miracle, mais une analyse complémentaire. De nombreux problèmes sont détectables dans un crawl, grâce à l’oeil d’un expert SEO, mais l’analyse de logs peut aider à identifier des problèmes technique difficilement détectables et optimiser le maillage du site.

Si vous souhaitez échanger à ce sujet avec nos experts, n’hésitez pas à nous suivre sur Twitter.

SEOment vôtre,